- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:45.

- Viimati modifitseeritud 2025-01-22 17:23.

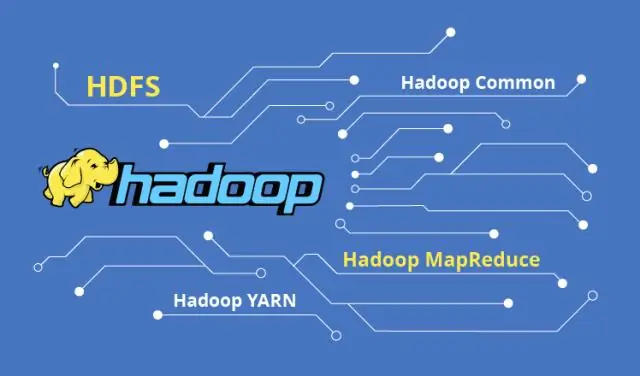

1) Väike failiprobleem sisse HDFS : Hoiab palju väikesed failid mis on äärmiselt väiksem kui ploki suurust ei saa tõhusalt käsitleda HDFS . Lugedes läbi väikesed failid hõlmab palju otsinguid ja palju hüppamist andmesõlmede vahel andmesõlmede vahel, mis on omakorda ebatõhus andmetöötlus.

Lisaks sellele, millised failid tegelevad Hadoopi väikeste failiprobleemidega?

1) HAR ( Hadoop Arhiiv) Failid on tutvustatud tegeleda väikese failiprobleemiga . HAR on lisanud peal oleva kihi HDFS , mis pakuvad liidest faili ligipääsemine. Kasutades Hadoop arhiivikäsk, HAR failid luuakse, mis jookseb a MapReduce töö pakkida failid arhiveeritakse väiksem mitu HDFS-failid.

Lisaks, kas ma saan HDFS-is mitu faili kasutada erineva suurusega plokki? Vaikimisi suurus kohta blokk on 64 MB. sina saab muutke seda vastavalt teie nõudele. Teie küsimusele tulles jah, sina saab luua mitu faili varieerides plokkide suurused aga seda reaalajas tahe ei soosi tootmist.

Veelgi enam, miks HDFS ei käsitle väikseid faile optimaalselt?

Probleemid väikesed failid ja HDFS iga faili , kataloog ja blokeeri HDFS on kujutatakse nimesõlme mälus objektina, millest igaüks võtab rusikareeglina enda alla 150 baiti. Lisaks HDFS ei ole mõeldud tõhusaks juurdepääsuks väikesed failid : see on peamiselt mõeldud suurte voogesituse jaoks failid.

Miks on Hadoop aeglane?

Aeglane Töötlemiskiirus Selle ketta otsimine võtab aega, muutes kogu protsessi väga heaks aeglane . Kui Hadoop töötleb andmeid väikeses mahus, see on väga aeglane suhteliselt. See sobib ideaalselt suurte andmekogumite jaoks. Nagu Hadoop mille keskmes on paketttöötluse mootor, selle kiirus reaalajas töötlemiseks on väiksem.

Soovitan:

Mis on Hadoopi töögraafik?

Tööde ajakava koostamine. Tööde ajastamise abil saate prioritiseerida MapReduce'i töid ja YARN-i rakendusi, mis töötavad teie MapR-klastris. Vaikimisi tööplaneerija on Fair Scheduler, mis on loodud tootmiskeskkonna jaoks, kus on mitu kasutajat või rühma, kes võistlevad klastri ressursside pärast

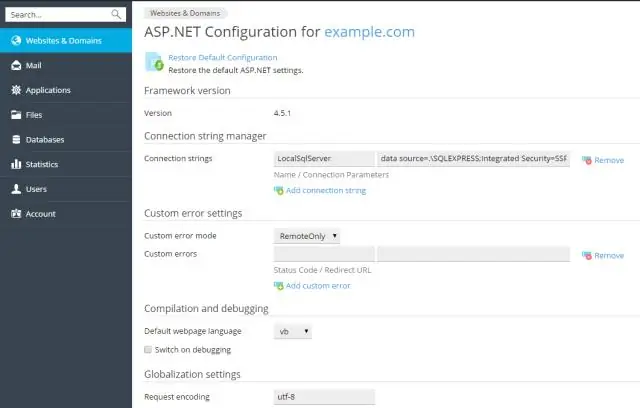

Mis on failide üleslaadimine asp netis?

ASP.NET – failide üleslaadimine. ASP.NET-il on kaks juhtelementi, mis võimaldavad kasutajatel faile veebiserverisse üles laadida. Kui server on postitatud failiandmed kätte saanud, saab rakendus need salvestada, kontrollida või ignoreerida

Mis on failide salvestamine AWS-is?

Failide salvestusruum. Pilvefailide salvestamine on meetod andmete salvestamiseks pilves, mis tagab serveritele ja rakendustele juurdepääsu andmetele jagatud failisüsteemide kaudu. See ühilduvus muudab pilvefailide salvestamise ideaalseks töökoormuse jaoks, mis tugineb jagatud failisüsteemidele ja pakub lihtsat integreerimist ilma koodi muutmata

Mis on failide blokeerimine?

Andmete plokkidesse panemise protsessi nimetatakse blokeerimiseks, deblokeerimist aga plokkidest andmete ekstraheerimiseks. Muud failisüsteemid, nagu ZFS, toetavad muutuvaid ploki suurusi. Tavaliselt eraldab plokksalvestuse failisüsteem või andmebaasihaldussüsteem (DBMS) rakenduste ja lõppkasutajate jaoks

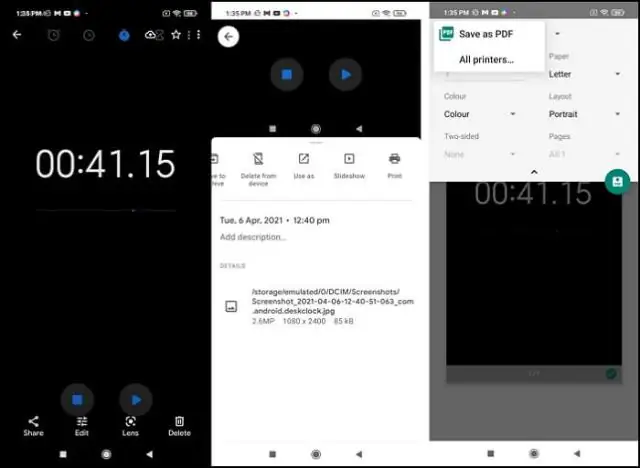

Mis on parim viis failide võrgus jagamiseks?

Parimad viisid failide edastamiseks Dropbox. Google Drive. WeTransfer. Saada ükskõik kuhu. Hightail. MediaFire. Kast. Loid