- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:45.

- Viimati modifitseeritud 2025-01-22 17:23.

Kuigi Säde toetab laadimist failid alates kohalik failisüsteemi, nõuab see, et failid on saadaval samal teel kõigis teie klastri sõlmedes. Mõned võrgufailisüsteemid, nagu NFS, AFS ja MapR-i NFS-kiht, on kasutajale avatud tavalise failisüsteemina.

Seejärel võib ka küsida, kuidas käivitada säde kohalikus režiimis?

sisse kohalik režiim , säde töökohad jooksma ühes masinas ja käivitatakse paralleelselt mitme keermestuse abil: see piirab paralleelsust (maksimaalselt) teie masina tuumade arvuga. To jooksma töökohad sisse kohalik režiim , peate esmalt reserveerima masina interaktiivses SLURM-i kaudu režiimis ja logige sisse.

Lisaks ülalolevale, mis on SC textFile? tekstifail on meetod org. apache. SparkContext klass, mis loeb a tekstifail HDFS-ist, kohalikust failisüsteemist (saadaval kõigis sõlmedes) või mis tahes Hadoopi toetatud failisüsteemi URI-st ja tagastage see stringide RDD-na.

Mis on sellega seoses sädefail?

The Sädefail on dokument, kus hoiate kogu oma loomingulist headust. Selle määratles autor Stephen Johnson. Nii et selle asemel, et keset ööd Post-it®-ile märkmeid kraapida või erinevaid ajakirju ideedele pühendada, pange kõik oma kontseptsioonid ühte faili.

Mis on paralleelselt kogumise säde?

Kirjeldame hajutatud andmekogumitega toiminguid hiljem. Paralleelsed kollektsioonid luuakse JavaSparkContexti kutsumisega paralleelseks meetod olemasoleval Kollektsioon oma draiveriprogrammis. Selle elemendid kogumine kopeeritakse, et moodustada hajutatud andmestik, mida saab paralleelselt kasutada.

Soovitan:

Kas Python saab ZIP-faile lugeda?

Pythoni abil ZIP-failidega töötamiseks kasutame sisseehitatud pythoni moodulit nimega zipfile. print ('Valmis!' ZipFile on zip-faili mooduli klass ZIP-failide lugemiseks ja kirjutamiseks. Siin impordime zip-faili moodulist ainult klassi ZipFile

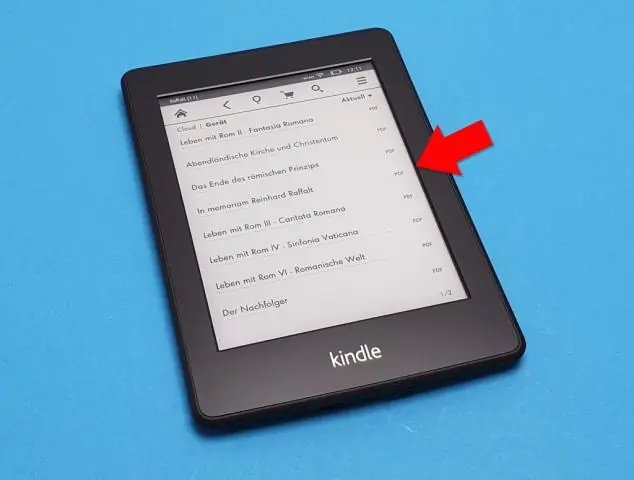

Kas finaal saab lugeda PDF-faile?

Pro-näpunäide: saate faili avada ka inFinale, valides faili leidjas ja paremklõpsates. Seejärel valige "Open with…" ja valige programmiribal Finale. Palju õnne! Olete PDF-faili ScanScore'i abil edukalt Finale'i importinud

Kas nook saab lugeda PDF-faile?

Dokumendid, mida saate Nookinclude PDF-i lisada, mis võivad olla raamatud või muud lühemad dokumendid. Nookis olevaid PDF-e saab lugeda nagu kõiki teisi ostetud raamatuid ja saate seadme sünkroonida, kopeerides dokumendid arvutist Nooki. Topeltklõpsake oma Nooki draivil kaustal „Raamat” või „Dokumendid”

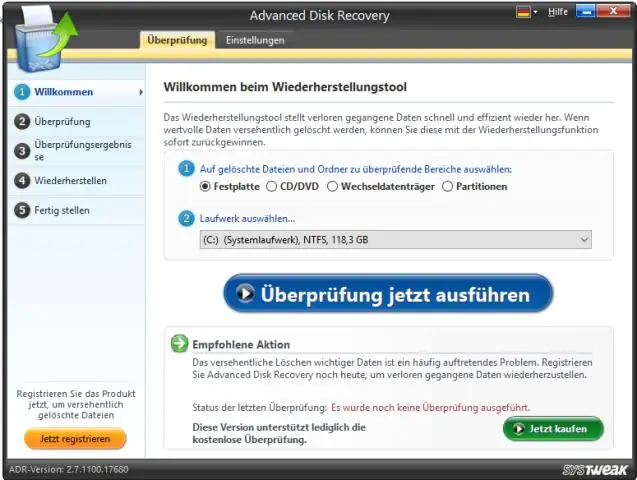

Kas Windows 10 saab lugeda töötlemata faile?

Windows 10 ei paku toorpildifailide eelvaate loomulikku tuge, mis tähendab, et kasutajad ei saa vaadata pisipilte ega metaandmeid rakenduses Photos Windows File Exploreris. Microsoftil on aga lahendus fotograafidele, kes seda võimalust vajavad, ja seda nimetatakse töötlemata pildi laiendiks

Kas Python saab lugeda.MAT-faile?

Alates Matlabi versioonist 7.3 salvestatakse matifailid tegelikult vaikimisi HDF5-vormingus (välja arvatud juhul, kui kasutate salvestamise ajal lippu -vX, vt Matlabist). Neid faile saab Pythonis lugeda, kasutades näiteks paketti PyTables või h5py