- Autor Lynn Donovan [email protected].

- Public 2024-01-18 08:23.

- Viimati modifitseeritud 2025-01-22 17:23.

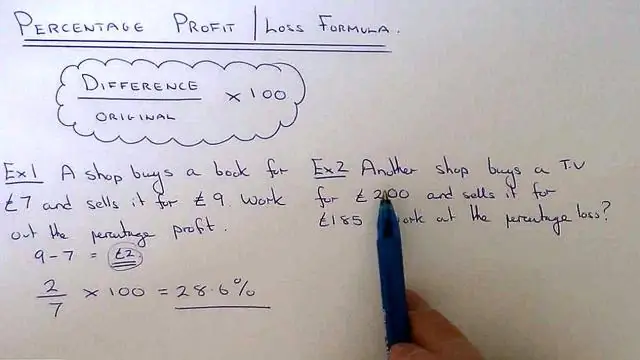

Kordade loendist DataFrame'i loomiseks järgin neid samme:

- Loo a nimekirja kordadest. Iga korteež sisaldab inimese nime koos vanusega.

- Loo RDD alates nimekirja eespool.

- Teisenda iga korteež rida.

- Loo a DataFrame rakendades sqlContexti abiga RDD-le faili createDataFrame.

Seda silmas pidades, kuidas teisendada DataFrame Pythonis loendiks?

- 1. toiming: teisendage andmeraam pesastatud Numpy massiiviks, kasutades DataFrame.to_numpy(), st.

- 2. samm: teisendage 2D Numpy massiiv loendite loendiks.

- 1. samm: transponeerige andmeraam, et teisendada read veergudeks ja veerud ridadeks.

- 2. samm: teisendage andmeraam pesastatud Numpy massiiviks, kasutades DataFrame.to_numpy()

Lisaks, mis on säde DataFrame? A Spark DataFrame on jagatud andmete kogum, mis on organiseeritud nimega veergudesse, mis pakub toiminguid agregaatide filtreerimiseks, rühmitamiseks või arvutamiseks ja mida saab kasutada koos Säde SQL. Andmeraamid saab koostada struktureeritud andmefailidest, olemasolevatest RDD-dest, Hive'i tabelitest või välistest andmebaasidest.

Tea ka, mis on PySpark SQL?

Spark SQL on Säde struktureeritud andmetöötluse moodul. See pakub programmeerimise abstraktsiooni nimega DataFrames ja võib toimida ka hajutatud raamina SQL päringumootor. See võimaldab muutmata Hadoop Hive päringuid olemasolevatel juurutustel ja andmetel käitada kuni 100 korda kiiremini.

Kas spark DataFrame'id on muutumatud?

sisse Säde sa ei saa - Andmeraamid on muutumatu . Sa peaksid kasutama.

Soovitan:

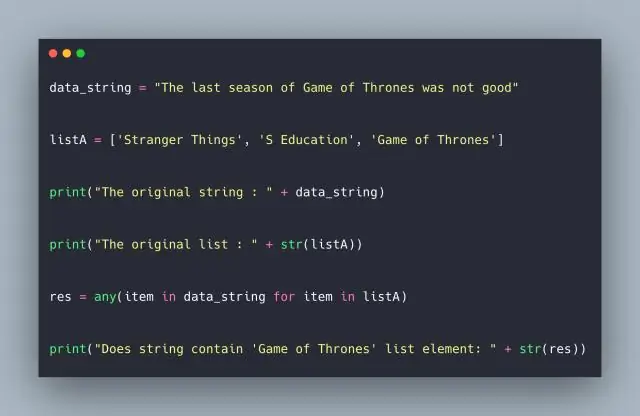

Kuidas ma saan itereerida Panda DataFrame'i kaudu?

Pandadel on iterrows() funktsioon, mis aitab teil andmeraami iga rida läbida. Pandade iterrows() tagastab iteraatori, mis sisaldab iga rea indeksit ja iga rea andmeid seeriana. Kuna iterrows() tagastab iteraatori, saame iteraatori sisu vaatamiseks kasutada järgmist funktsiooni

Mis kasu on loendist pythonis?

Loendid on üks neljast Pythoni sisseehitatud andmestruktuurist koos korteežide, sõnaraamatute ja komplektidega. Neid kasutatakse tellitud esemete kogumi salvestamiseks, mis võivad olla erinevat tüüpi, kuid tavaliselt mitte. Komaga eraldatakse loendis sisalduvad ja nurksulgudes olevad elemendid

Kuidas pandade DataFrame'i maha jätta?

Ridade ja veergude kustutamiseks DataFramesist kasutab Pandas funktsiooni "drop". Veeru või mitme veeru kustutamiseks kasutage veeru(de) nime ja määrake „teljeks” 1. Alternatiivina, nagu allolevas näites, on Pandasse lisatud parameeter „veerud”, mis lõikab välja vajadus "telje" järele

Kas saate lingitud loendist binaarselt otsida?

Jah, lingitud loendis on binaarne otsing võimalik, kui loend on järjestatud ja teate loendis olevate elementide arvu. Kuid loendi sortimisel pääsete juurde ühele elemendile korraga, kasutades kursorit sellele sõlmele, st kas eelmisele või järgmisele sõlmele

Mis kasu on lingitud loendist?

Lingitud loendid on lineaarsed andmestruktuurid, mis hoiavad andmeid üksikutes objektides, mida nimetatakse sõlmedeks. Need sõlmed sisaldavad nii andmeid kui ka viidet loendi järgmisele sõlmele. Lingitud loendeid kasutatakse sageli nende tõhusa sisestamise ja kustutamise tõttu