- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:46.

- Viimati modifitseeritud 2025-01-22 17:23.

Tavapäraselt öeldes ise - tähelepanu mehhanism võimaldab sisenditel üksteisega suhelda (“ ise ”) ja uurige, kellele nad peaksid rohkem maksma tähelepanu kuni ( tähelepanu ”). Väljundid on nende interaktsioonide agregaadid ja tähelepanu hinded.

Lisaks, mis on enesetähelepanu?

Ise - tähelepanu , mida mõnikord nimetatakse intra- tähelepanu on an tähelepanu mehhanism, mis seob ühe jada erinevaid asukohti, et arvutada jada esitus.

Samuti, mis on enesetähelepanu süvaõppes? Esiteks määratleme, mida ise - Tähelepanu " on. Cheng jt oma artiklis "Long Short-Term Memory-Networks for Masin Lugemine”, määratletud ise - Tähelepanu ühe jada või lause erinevate positsioonide seostamise mehhanismina, et saavutada erksam esitus.

Mis on sellega seoses tähelepanu mehhanism?

Tähelepanu mehhanism võimaldab dekoodril väljundi genereerimise igal etapil jälgida lähtelause erinevaid osi. Selle asemel, et kodeerida sisendjada ühte fikseeritud kontekstivektorisse, laseme mudelil õppida, kuidas luua konteksti vektorit iga väljundi ajaetapi jaoks.

Mis on tähelepanupõhine mudel?

Tähelepanu - põhinevad mudelid kuuluvad klassi mudelid mida tavaliselt nimetatakse järjestusest jadasse mudelid . Nende eesmärk mudelid , nagu nimigi ütleb, loob see väljundjada, mille sisendjada on üldiselt erineva pikkusega.

Soovitan:

Kuidas võrdlemine ja vahetamine toimib?

Võrdle ja vaheta. Arvutiteaduses on võrdlemine ja vahetamine (CAS) sünkroonimise saavutamiseks kasutatav mitmelõimenduses aatomikäsk. See võrdleb mälukoha sisu antud väärtusega ja ainult siis, kui see on sama, muudab selle mälukoha sisu uueks etteantud väärtuseks

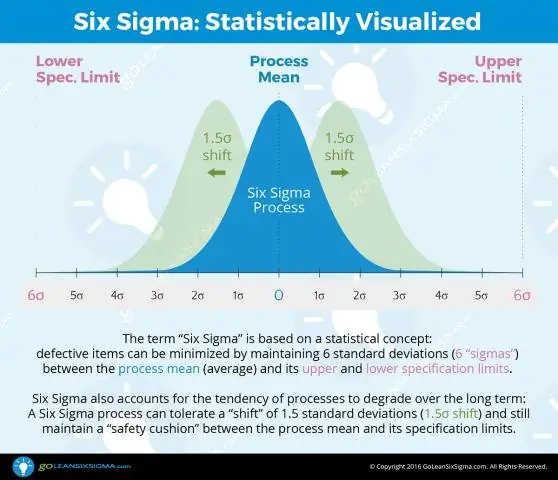

Mis on Six Sigma ja kuidas see toimib?

Six Sigma on distsiplineeritud ja kvantitatiivne lähenemisviis, mis hõlmab tootmis-, teenindus- või finantsprotsesside määratletud mõõdikute täiustamise süsteemi ja protsessi loomist. Parendusprojektid järgivad distsiplineeritud protsessi, mis on määratletud nelja makrofaasi süsteemiga: mõõtmine, analüüsimine, täiustamine, juhtimine (MAIC)

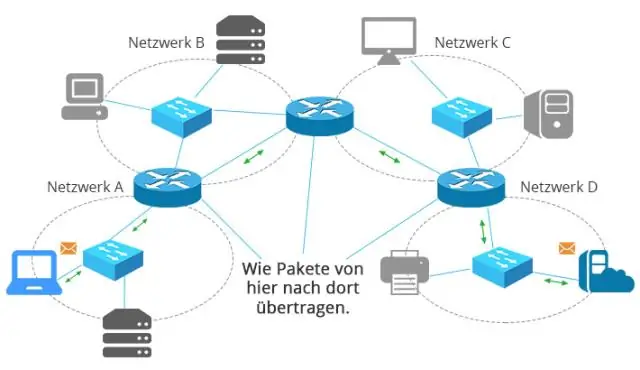

Mis on marsruutimine ja kuidas see toimib?

Marsruutimine on IP-pakettide ühest võrgust teise edastamise protsess. Ruuter on seade, mis ühendab võrke ja suunab liiklust nende vahel. Ruuteril peab olema vähemalt kaks võrgukaarti (NIC), millest üks on füüsiliselt ühendatud ühe võrguga ja teine teise võrguga

Kuidas reageerimisseisund toimib?

Iga Reacti komponendi süda on selle olek, objekt, mis määrab, kuidas see komponent renderdab ja käitub. Teisisõnu, "olek" võimaldab teil luua dünaamilisi ja interaktiivseid komponente

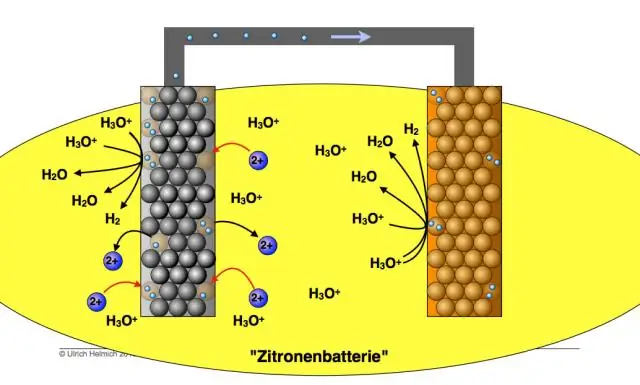

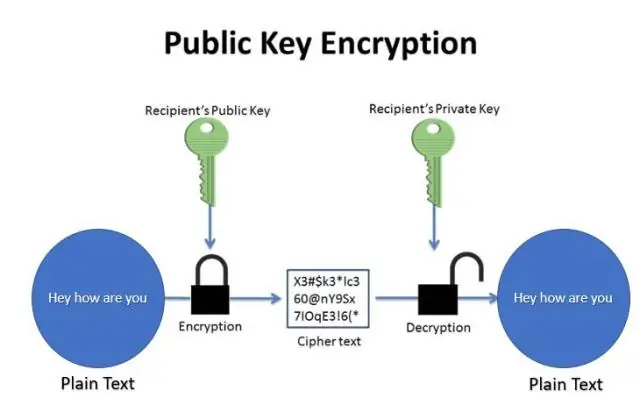

Kuidas krüpteerimine toimib, viktoriin?

Saatja kirjutab lihtteksti ja krüpteerib selle salajase võtmega. Krüpteeritud sõnum saadetakse vastuvõtjale, kes suudab sõnumi sama salajase võtme abil dekrüpteerida. Kuidas asümmeetrilise võtme krüpteerimine töötab? Saatja kirjutab sõnumi ja krüpteerib selle avaliku võtmega